З розвитком технологій та зміною запитів аудиторії в інтернеті — змінюється і контент. Якщо раніше ми змагалися за щільність ключових слів, то сьогодні успіх контенту залежить від його здатності бути зрозумілим і корисним для AI-систем, таких як Google AI, Perplexity та Claude.

Фахівці Promodo пояснили, як оптимізувати контент для LLM, чому AI-системи оцінюють його інакше, ніж традиційний пошук, і як перейти від застарілих методів до створення контенту, який буде індексуватися та цитуватися штучним інтелектом.

Як оцінюється контент у звичайному пошуку

На самому початку, було закладено основний принцип: результати пошуку повинні відповідати поставленому користувачем питанню. Логіка підбору відповіді (сторінки сайту в пошуку) була досить примітивною, що дозволяло маніпулювати видачею. В цей час було достатньо додати більше ключових фраз у текст, або й взагалі заспамати в поле keywords — і ось ти вже номер один у видачі. Це досить швидко виправили.

Векторні моделі, які використовує Google:

・GloVe (Global Vectors for Word Representation) – це модель навчання векторів слів, розроблена у Стенфордському університеті. Вона створює векторне уявлення слів, яке відображає семантичні відносини між словами, враховуючи кореляцію в матриці частот спільних зустрічей.

・Word2vec — це одна з методик обробки природної мови. Алгоритм word2vec використовує нейромережну модель для навчання пов'язаностей слів із великого корпусу тексту

・та інші.

Google побудував складну систему з машинним навчанням та безліччю алгоритмів, які функціонують та оцінюють контент незалежно та постійно впливають один на одного.

Хронологія розвитку алгоритмів Google

2011: Боротьба з «фермами контенту» (Panda Update) - перший удар, коли простого додавання ключових фраз стало недостатньо;

Google Panda — це частина пошукового алгоритму Google, призначена для зниження рейтингу веб-сайтів з низькоякісним, дубльованим або спамним контентом. Основна мета оновлення полягала в тому, щоб відсіяти сайти, які не додають цінності користувачам, і знизити їх видимість у пошукових результатах.

- 2015: Введення RankBrain. Системи машинного навчання, яка допомагає краще розуміти запити користувачів і контекст сторінок. По суті це можна вважати першим кроком до майбутнього штучного інтелекту.

- 2019: Оновлення BERT. Google впровадив BERT (Bidirectional Encoder Representations from Transformers), модель, яка дозволяє краще розуміти контекст слів у запитах. Особливість полягає в тому, тепер недостатньо додавати ключові фрази, потрібно «вгадувати» кінцевий інтент користувача, який формує запит у пошуку;

У 2023 році зʼявилося оновлення Helpful Content — з цього моменту розпочинається ера пошуку і детального аналізу вже якості усього контенту, а не просто входження ключових слів.

Сформувався наступний алгоритм до аналізу та пошуку «ідеального контенту» для пошукової системи:

1. Сторінки з контентом в 1000-2000 слів мають більше шансів на високі позиції, тому що вони зазвичай покривають тему більш повно.

2. Використання ключових слів: пошукові системи шукають збіги між запитом і контентом на сторінці.

3. Для правильної інтеграції ключових слів у контент, щоб сподобатися пошуковій системі, використовуються додаткові показники:

- TF (Term Frequency) — частота появи певного терміна на сторінці. Вищий TF може свідчити про те, що цей термін важливий для контексту, але його не можна використовувати надмірно;

- DF (Document Frequency) — кількість документів у всьому індексі, що містять цей термін. Якщо термін має високий DF, це означає, що він часто зустрічається, і, ймовірно, він менш специфічний або загальний;

- IF (Inverse Frequency) — обернена частота терміну в документі. Це важливий параметр для визначення того, наскільки рідкісне або важливе слово для конкретного контексту або сторінки;

4. Використання LSI-фраз дозволяло додати тексту більшої релевантності та експертності у порівнянні з конкурентами.

LSI (Latent Semantic Indexing) — це метод, який використовується пошуковими системами, включно з Google, для розуміння контексту та значення тексту, а не просто для підрахунку ключових слів.

5. Використання ключових фраз у мета тегах дозволяє досить чітко вказувати пошуковій системі на головну задачу, для якої було створено сторінку сайту.

6. Робота зі структурою текстів. Першочергово це використання заголовків Н1-Н6, які дозволяють додатково підсвічувати не лише підтеми тексту, а й вказувати важливість конкретного інтенту на сторінці і корелювати релевантність.

Однак з розвитком технологій LLM традиційні методи більше не працюють.

LLM, або велика мовна модель (від англ. Large Language Model) — це тип штучного інтелекту, який спеціалізується на обробці та генерації людської мови.

Чим відрізняється аналіз контенту AI-ботами

Система GPT-3 була представлена в 2020 році, і лише за 2 роки стала доступною для масового користувача.

Ми більше не оптимізуємо — ми «інженеримо».

Mike King (iPullRank), конференція SMX Advanced 2025.

Сьогодні LLM представлені не лише великими гравцями, а й доступні для побудови в кастомному режимі для окремої компанії, бізнесу чи навіть користувача. Ви можете генерувати тексти, зображення, відео чи просто підтримувати спілкування у чаті.

Різні моделі мають різну логіку роботи та використовують різні джерела інформації для навчання. Розглянемо далі на прикладах, деякі аспекти, що дозволять вам краще зрозуміти як працюють ШІ зсередини.

Бути інтелектом для AI — значить бути джерелом його відповідей.

Will Scott, конференція SMX Advanced 2025

AI Overviews

Google підтверджує використання техніки «query fan-out» в AI Overviews: система запускає кілька паралельних запитів, щоб побудувати одну відповідь. Це означає, що для одного запиту ваша сторінка має шанс бути залученою навіть якщо вона не точно релевантна початковому запиту — головне, щоб вона відповідала на підзапити. Підтвердженням цієї гіпотези є проведений експеримент DEJAN.

«Query fan-out» — це техніка в системах штучного інтелекту, зокрема в системах пошуку, яка передбачає розбиття початкового запиту користувача на кілька пов'язаних підзапитів.

Якщо ви хочете розібратися достеменно, як це працює, рекомендую переглянути патент Google.

Perplexity

Нещодавно у дослідженні, проведеному Metehan Yesilyurt, виявлено 59 шаблонів ранжування, що використовуються в Perplexity, разом із криптографічними схемами для оцінки контенту.

Однак варто зазначити, що деякі аспекти цієї системи можуть залишатися закритими або недостатньо підтвердженими через обмежений доступ до деталей її внутрішньої роботи.

Perplexity використовує складну трирівневу (L3) систему переранжування для пошуку об'єктів, яка дозволяє принципово змінювати результати пошуку. Система включає механізми безпеки, які можуть повністю відкидати набори результатів, якщо вони не відповідають пороговим значенням якості, гарантуючи, що користувачі бачать лише високонадійні збіги.

Розглянемо детально параметри, які вдалося виявити, і як вони впливають на контент, який оцінюється пошуковою системою ШІ.

У підсумку бачимо, що система переранжування L3, не просто додатково перевіряє сформовані результати, а може повністю відхиляти результати пошуку за сутністю, якщо немає підтвердження якості.

Успішний показ вашого контенту, вимагає не лише оптимізації ключових слів, а й тематичної авторитетності та сигналів якості, які задовольняють оцінку машинного навчання.

Дослідник виявив, що у системі ранжування Perplexity є існування авторитетних доменів, налаштованих вручну.

Ключові авторитетні домени за категоріями (не повний список):

1. Електронна комерція та покупки:

- amazon.com, ebay.com, walmart.com, bestbuy.com

- etsy.com, target.com, costco.com, aliexpress.com

2. Продуктивність та професійні інструменти:

- github.com, notion.so, slack.com, figma.com

- jira.com, asana.com, confluence.com, airtable.com

3. Комунікаційні платформи:

- whatsapp.com, telegram.org, discord.com

- messenger.com, signal.org, microsoftteams.com

4. Соціальні та професійні мережі:

- linkedin.com, twitter.com, reddit.com

- facebook.com, instagram.com, pinterest.com

5. Освітні ресурси:

- coursera.org, udemy.com, edx.org

- khanacademy.org, skillshare.com

6. Подорожі та бронювання:

- booking.com, airbnb.com, expedia.com

- kayak.com, skyscanner.net

Між платформами Perplexity та YouTube виявили сильний зв’язок: коли відео на YouTube використовують назви з точним збігом із трендовими запитами Perplexity, вони отримують значні переваги в рейтингу на обох платформах. Перевірте результати експерименту власноруч тут.

Для формування рейтингу контенту, який буде задіяний у результатах, використовується складна система категоризації намірів користувачів:

Контент, який відповідає цим попередньо запрограмованим категоріям пропозицій, отримує кращу видимість, оскільки він відповідає заздалегідь визначеним цінним намірам користувачів.

Отже, контент проходить наступну перевірку:

Важливо, що ці етапи перевірки контенту мають ручні конфігурації та заздалегідь визначені шаблони для оптимізації.

Надаємо зведену таблицю з факторами ранжування:

Детальне вивчення факторів та їх впливу, може суттєво вам допомогти у покращенні ранжування в системі Perplexity.

Claude

В кінці червня 2025 було оголошено про витік внутрішніх даних з документації ШІ Claude. Відомі західні спеціалісти, Ганс Кроненберг та Алейди Соліс, провели аналіз інформації та змогли виділити важливі тезиси для всіх нас.

Ключові висновки:

- Claude використовує 4 режими для пошуку:

- never_search,

- do_not_search_but_offer,

- single_search,

- research.

- Claude використовує режим пошуку never_search, коли потрібно відповісти на питання, які містять загальновідому незмінну інформацію.

- Режим single_search використовується для пошуку окремих фактів при формуванні відповіді на прості питання.

LLM не просто шукають — вони міркують. Потрібно «володіти експертизою», щоб потрапити в reasoning-моделі. Глибокий пошук = ваша глибока експертиза.

Crystal Carter, конференція SMX Advanced 2025.

- Для складних запитів Claude генерує відповідь в режимі research, використовуючи 2–20 викликів пошукових інструментів.

Що ця інформація дає нам, як SEO-спеціалістам:

- Автори дослідження кажуть: ні авторитетність, ні бренд не мають значення. Важливо лише мати чітко структуровану відповідь, яку бот ШІ зможе легко проаналізувати, розбивши на окремі частини..

- Створюйте контент, який користувачі шукають поза межами AI-відповідей (таблиці, інструменти, редакційна аналітика).

- Переходьте від традиційного SEO до оптимізації під цитування: пишіть так, щоб ваші фрази можна було легко інтегрувати в AI-відповіді.

ChatGPT

Ще один дослідник, Jérôme Salomon, активно тероризував команду підтримки ChatGPT, щоб дізнатися деталі про пошук ChatGPT. Ми знаємо, що пошук відбувається за наступними етапами:

- Спочатку ШІ ChatGPT перетворює запит на один або кілька запитів до Bing

- Далі Bing надсилає список результатів з пошуку

- Потім AI-bot сканує добірку релевантних джерел

- І на завершення: ChatGPT формує відповідь, в яку включає контент з релевантних цитат.

Автор дослідження поцікавився у служби підтримки, як ChatGPT обирає URL-адреси з довгого списку результатів пошуку. І йому надали відповідь.

«На рішення про те, які сторінки сканувати, в першу чергу впливає релевантність заголовка, контент у фрагменті, свіжість інформації та надійність домену.»

Служба підтримки ChatGPT

Якщо вам цікаво власноруч переглянути, як ChatGPT відбирає джерела, для своєї відповіді, то ось коротка інструкція:

1. Напишіть ваше питання (промт) у ChatGPT із увімкненим Search.

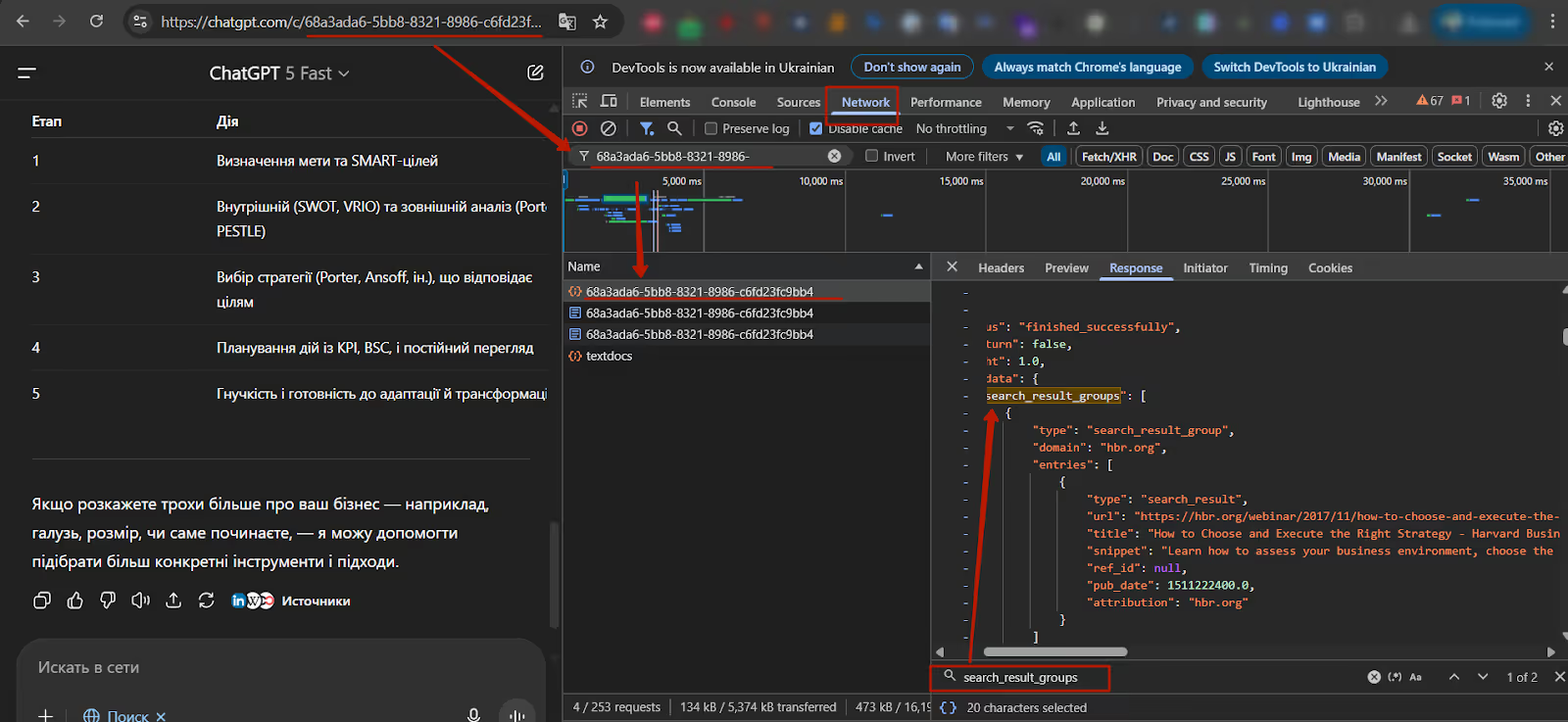

2. Відкрийте DevTools (ПКМ → Inspect або F12).

3. Перейдіть на вкладку Network → оновіть сторінку через ctrl+r наприклад.

4. Знайдіть запит із /c/{код} в URL. Саме він містить JSON-відповідь.

5. Клікніть по ньому → відкрийте вкладку Response.

Що ви побачите у JSON-відповіді:

- «thoughts» — опис логіки, яку ChatGPT застосував для розширення запиту. Дуже корисно для розуміння LLM reasoning.

- «search_queries» — точні запити, які були відправлені в Bing. Якщо ви хочете потрапити в результати, вам треба ранжуватись саме по цим фразам.

- «search_result_groups» — джерела, які були витягнуті, для кожного результату, ви отримуєте:

- Адреса URL

- Назва (title)

- Сніпет (зазвичай базується на description)

- Позиція в рейтингу

- Метадані (наприклад, дата публікації)

Примітка: на момент написання статті вдалося отримати лише один параметр «search_result_groups». Але тут нам допоможе ще один експерт - Mark Williams-Cook.

Рекомендації по оптимізації контенту на сайті під пошук AI

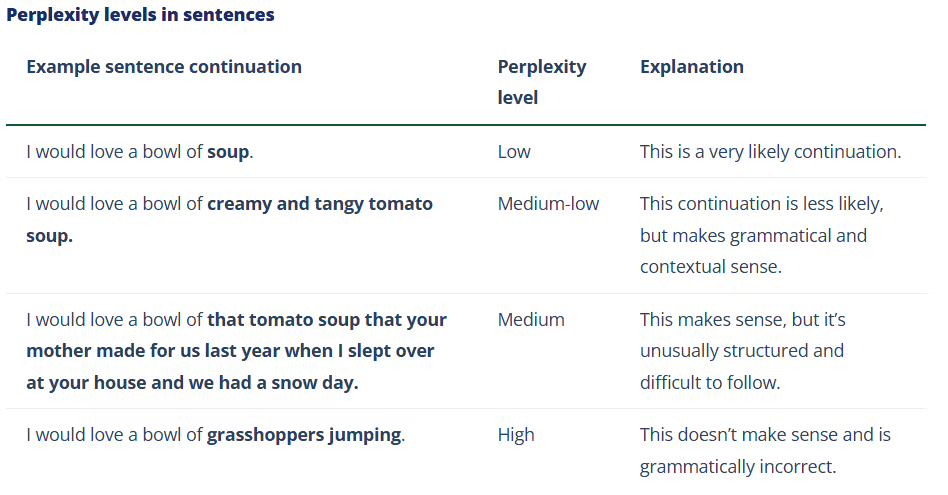

Перше на що варто звернути увагу: в традиційному SEO ми оптимізували сторінку сайту в цілому, але LLM не цікавить уся сторінка чи весь контент, а лише частини контенту — так звані chunks.

Чанки (chunks) — це невеликі, самостійні частини контенту, які об'єднуються для створення більшої статті або сторінки.

Щоб ваш контент потрапляв у відповіді AI, важливо враховувати нову структуру взаємодії між текстами, оптимізованими під LLM. Це означає, що потрібно формувати короткі, логічно завершені фрагменти тексту, які можуть бути легко інтегровані в AI-відповіді.

Як це працює?

- Chunk — це окремий, логічно завершений фрагмент тексту довжиною ~100–300 токенів (75–225 слів), який модель LLM (ChatGPT, Claude, Gemini) може витягнути, проаналізувати та використати у формуванні своєї відповіді.

- Ці фрагменти не «збираються вручну», а обробляються автоматично. Якщо ви хочете потрапити у відповідь — необхідно формувати короткі логічно завершені думки.

- Навіть із величезними контекстними вікнами (GPT-4 Turbo — 128K токенів, Gemini 1.5 — до 2M), ці системи все одно працюють з окремими семантичними частинами, а не всім текстом.

Як потрібно оптимізувати контент на сторінці під AI

Структуруйте ваш текст у чанки. Для цього перш за все потрібно, врахувати наступні моменти:

- Використовуйте сутності. На відміну від ключових слів, сутності покладаються на контекстні зв'язки, щоб допомогти алгоритмам пошуку зрозуміти намір, що стоїть за пошуковим запитом, тому оптимізація сутностей набагато важливіша, ніж традиційна оптимізація ключових слів.

Сутність – це особа, об'єкт, місце або будь-яке інше поняття, яке можуть зрозуміти пошукові системи та LLM.

- Увесь текст повинен обов’язково бути розділений на частини за допомогою структурованих заголовків Н2-Н3. Але на відміну від звичайного SEO, формуйте заголовки, щоб вони описували конкретний інтент, який буде представлено в абзацах. Тепер недостатньо вписати ключові фрази у заголовок, якщо суть не буде розкрито у тексті — заголовок буде оцінено як не релевантний.

- Структура тексту також повинна поділятися на блоки. Дотримуйтесь правила: «один блок = одна ідея». На сьогодні боти-AI неспроможні виділити з тексту сутність, якщо вона розмита «водою» або між визначенням (питанням) і поясненням (відповіддю) є інформація про щось інше. Якщо ви розпочинаєте якусь тему в абзаці чи розділі — надавайте відповідь одразу без «ліричних» відступів.

Для embedding-алгоритмів важливо, щоб chunk мав чіткий, однорідний зміст.

- LLM системи краще розуміють чіткі, прямі речення. Метафори, жарти, ліричні відступи - погіршують семантичний аналіз пошукової системи ШІ. Пам’ятайте, що LLM шукає і витягує лише ті фрагменти, що стосуються запиту користувача.

Ми живемо в епоху open-book AI retrieval. Потрібен якісний, семантично структурований контент із чіткими темами та chunk-ами.

Dawn Anderson, конференція SMX Advanced 2025

- Структуризація контенту надзвичайно важлива: використовуйте не лише заголовки, а й таблиці, окремі бокси (блоки) з термінами. Приклад:

Приклад:

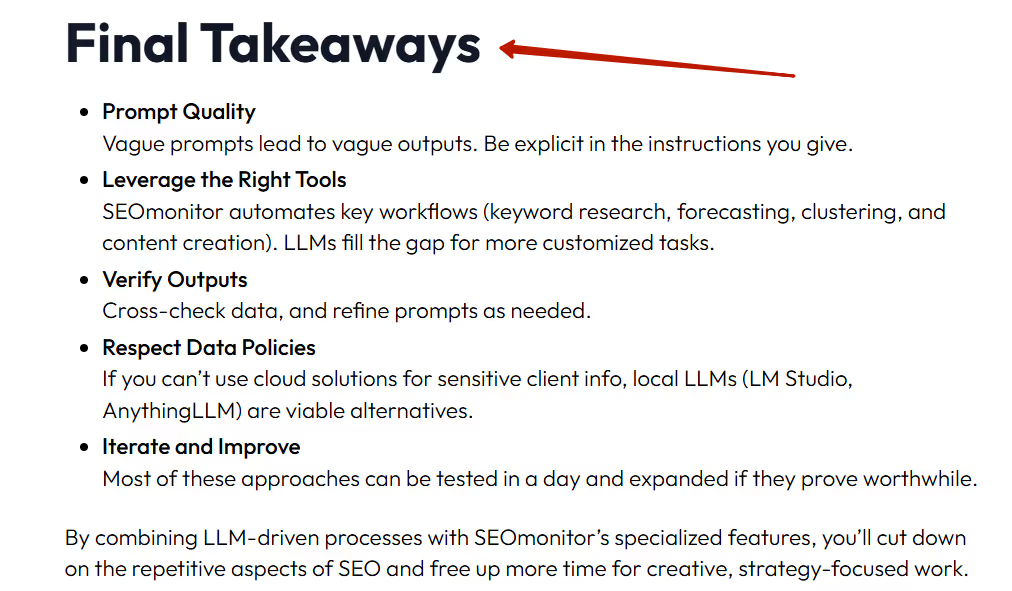

- З появою LLM, з’явилося нове поняття — це блок «Key takeaways», який є певним заключенням (summary) для LLM. Додавайте його після кожного розділу чи як скорочене прев’ю на початку. Приклади:

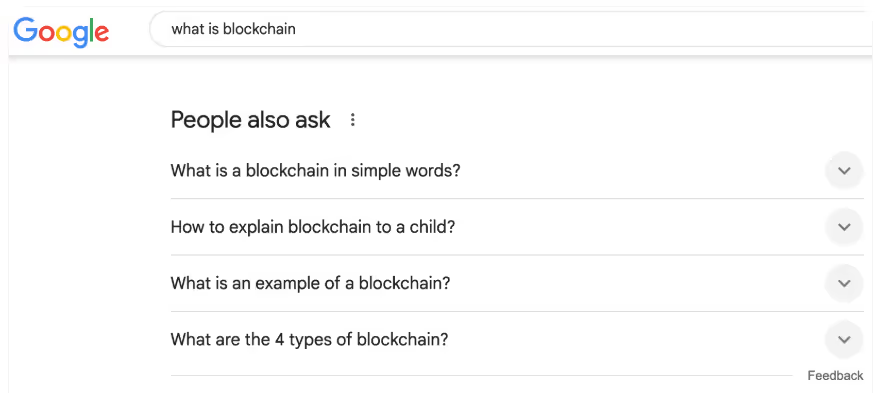

- LLM підбирає chunks, які відповідають природному формулюванню запиту. Тому використовуйте блоки звичайного пошуку: AlsoAsked, AnswerThePublic, People Also Ask.

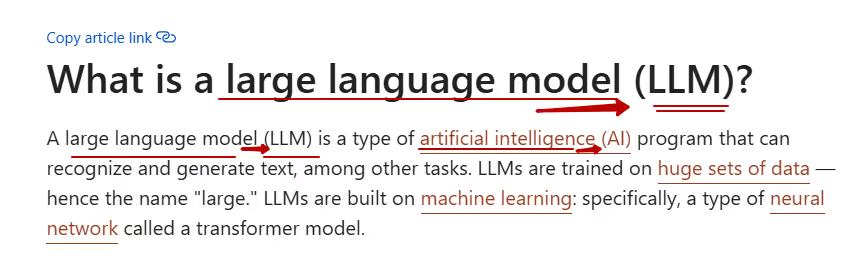

- LLM сьогодні не тільки галюцінують, але й часто є забудькуватими. Тому важливо розшифровувати абревіатури, давати пояснення термінам.

- Повторюйте важливі думки для вашого тексту в різних формулюваннях. На відміну від традиційного SEO, де враховується входження ключових фраз, LLM не шукає і не рахує однакові ключі — вона працює з векторами. Тому варто кілька разів згадувати ключову ідею в різних частинах статті з використанням різних описів.

- В розрізі всього сайту тепер важливо не просто перелінковувати контент між собою, а саме будувати внутрішню структуру — граф знань. Тепер ви, з кожним посиланням, відправляєте користувача і бота-АІ не до нового контенту, а до продовження і розширення ідей, які були отримані зі сторінки з першим контентом. Ваша внутрішня перелінковка повинна відображати карту змісту для всього контенту на сайті.

- Використовуйте FAQ-секції для прямих відповідей. Тепер блок FAQ це не збірник «ключових запитів» у формі запитань, а справжні питання, які цікавлять користувачів. Давайте конкретні відповіді в розмірі 50-100 слів. Формуйте питання так, як користувачі будуть запитувати у LLM. Дослідження підтверджують ефективність використання FAQ:

Висновок

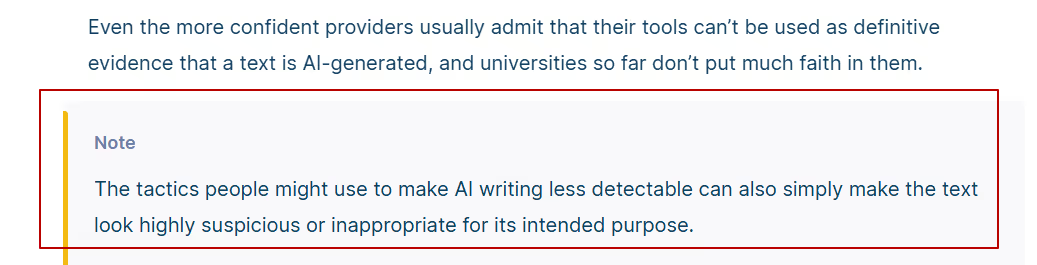

Сьогодні LLM в процесі становлення, тому вони постійно еволюціонують. Усі LLM мають багато спільного, але йдуть різними шляхами розвитку. Одні AI більше спираються на семантичний аналіз, а інші використовують ручні налаштування та враховують ряд додаткових факторів, які не залежать від якості контенту. Саме тому, те що працює для однієї системи пошуку ШІ, може не надати результатів в іншій.

Також на цю тему:

на розсилку